Wie lässt sich in der Programmierausbildung prüfen, ob Studierende Code verstehen, wenn sie ihn nicht mehr selbst schreiben müssen? Die Projektmesse in der Einführung in die Informatik erprobt ein Format, das Verständnis statt Urheberschaft bewertet.

Projektmesse im Irmler-Musiksaal, 2. Februar 2026. Foto: Tim Kipphan / Universität Bamberg

Projektmesse im Irmler-Musiksaal, 2. Februar 2026. Foto: Tim Kipphan / Universität Bamberg

Ausgangsproblem

In der Programmierausbildung stellt sich seit der Verfügbarkeit generativer KI-Werkzeuge eine grundsätzliche Frage: Wie lässt sich prüfen, ob Studierende Code verstehen, wenn sie ihn nicht mehr selbst schreiben müssen? Klassische Klausuren ohne Hilfsmittel bilden die spätere Berufspraxis nicht ab. Hausarbeiten und Projektabgaben können vollständig KI-generiert sein, ohne dass dies erkennbar wäre.

Im Rahmen von Baustein 06 (“Prüfungsformate”) erproben wir alternative Prüfungsformate, die Verständnis und Anwendungskompetenz in den Vordergrund stellen statt die Frage nach der Urheberschaft des Codes.

Das erprobte Format

In der Lehrveranstaltung “Einführung in die Informatik” (ca. 260 Prüflinge, Wintersemester 2025/26, inf.zone) haben wir eine öffentliche Projektmesse als freiwilliges Prüfungselement eingeführt. Das Format orientiert sich am CS50 Fair der Harvard University.

Studierende entwickeln ein eigenes Softwareprojekt mit selbstgewähltem Thema und präsentieren es auf einer öffentlichen Messe. Die Bewertung erfolgt durch strukturierte Interaktion am Stand: Live-Demo, Code-Walkthrough, Nachfragen zu Designentscheidungen. Die Nutzung von KI-Werkzeugen ist explizit erlaubt – bewertet wird, ob Studierende ihren Code erklären können und spontan skizzieren können, wie sie Änderungsvorschläge umsetzen würden.

Die Bewertung erfolgt auf einer Skala von 0–3 in drei Dimensionen (maximal 9 Punkte). Die Punktsumme wird zur Ermittlung der Bonuspunkte verdoppelt (maximal 18 Punkte). Weitere 2 Punkte sind durch die spätere Code-Abgabe erreichbar, die verpflichtend ist, um die Bonuspunkte im Falle einer bestandenen Abschlussklausur (E-Prüfung am Rechner) angerechnet zu bekommen.

Einbettung in den Kursablauf

Die Messe ist Teil eines dreiteiligen Ablaufs:

| Element | Zeitpunkt | Funktion | Punkte |

|---|---|---|---|

| Hackathon | 3 Tage vor Messe | Community-Building, niedrigschwelliger Support | 0 |

| Projektmesse | Semesterende | Live-Prüfung von Verständnis und Eigenleistung | 0-18 |

| Code-Abgabe | 2 Wochen nach Messe | Code, Dokumentation und Video | 0-2 |

Die Punkteverteilung (18:2) setzt ein bewusstes Signal: Die mündliche Interaktion zählt, nicht das abgegebene Artefakt.

Bewertungssystem

Wir bewerten drei Dimensionen auf einer Skala von 0–3:

Demo und Präsentation: Funktioniert der Prototyp? Ist er gut benutzbar und sieht er gut aus? Wird das gelöste Problem verständlich kommuniziert?

Code-Orientierung: Findet sich die Person im eigenen Code zurecht? Kann sie erklären, was an welcher Stelle passiert und wo Änderungen anzusetzen wären?

Eigenleistung: Gibt es eigene Ideen über den Status Quo hinaus? Kann die Person begründen, warum bestimmte Entscheidungen getroffen wurden?

Die Personen, die die Bewertung vornehmen, erhalten konkrete Nachfragen als Leitfaden: “Zeig mir im Code, wo dieses Feature passiert.” – “Was war die schwierigste Stelle?” – “Was würdest du noch draus machen, wenn du noch drei Monate Zeit hättest?”

Durchführung 2026

Die Messe fand am 2. Februar 2026 im Irmler-Musiksaal (WE5) der Universität Bamberg statt.

Organisation:

- 53 angemeldete Projekte in zwei Runden (15:00-16:15 Uhr, 16:15-17:30 Uhr)

- 49 tatsächlich präsentierte Projekte (4 No-Shows)

- 70 teilnehmende Studierende (Einzel- und Zweierteams)

- 9 bewertende Personen (je 3–7 Projekte zu bewerten)

- etwa 20 Personenstunden Aufwand für die Bewertung

Der vorgelagerte Hackathon dient dem Community-Building: Studierende knüpfen zwanglos Bekanntschaften und können anderen über die Schulter schauen.

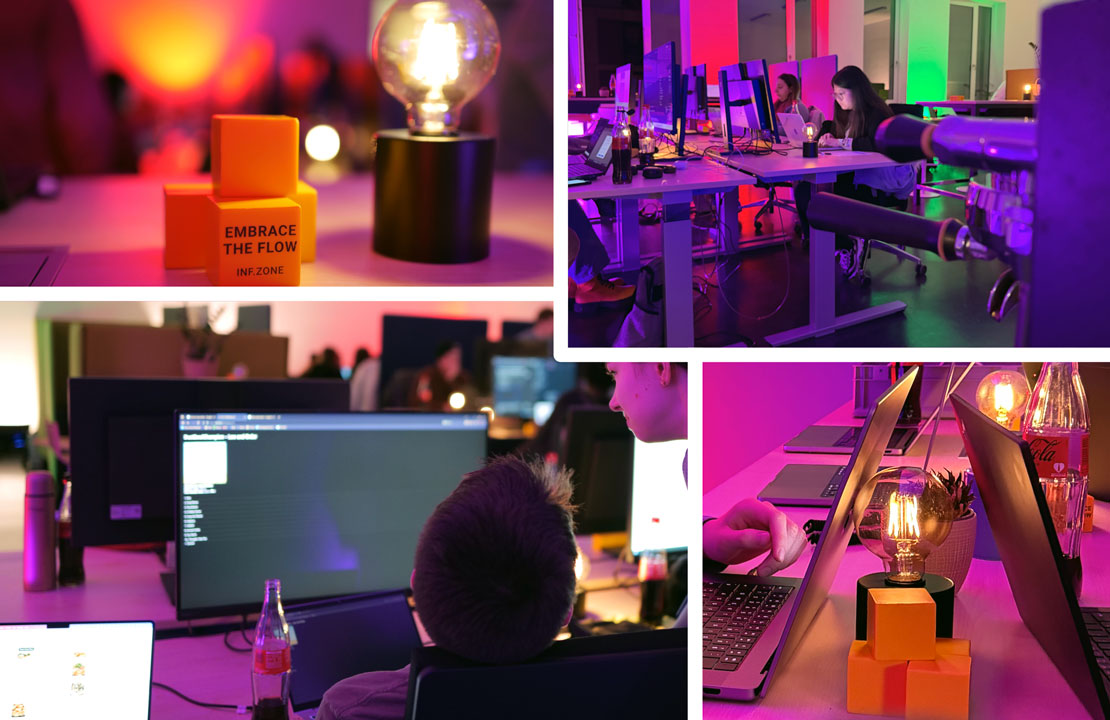

Hackathon drei Tage vor der Messe. Foto: Romy Schatzschneider / Universität Bamberg

Hackathon drei Tage vor der Messe. Foto: Romy Schatzschneider / Universität Bamberg

Auswertung der Bewertungen

Ein Risiko bei der Bewertung durch nur eine Person ist unzureichende Bewertungskonsistenz. Diesem Problem begegneten wir durch einen Bewertungsleitfaden mit Beschreibungen der Punkteniveaus (Rubric) und einem kurzen Briefing der bewertenden Personen.

Der Gesamtmittelwert lag bei 6,6 von 9 möglichen Punkten. Die Mittelwerte der einzelnen Bewerter schwankten zwischen 5,3 und 8,4 – eine Spannweite von 3,1 Punkten. Der mildeste Bewerter vergab im Schnitt drei Punkte mehr als die beiden strengsten.

Diese Varianz lässt sich nicht eindeutig interpretieren: Da jede Person andere Projekte sah (die Projekte wurden den bewertenden Personen zufällig zugelost), kann ein höherer Mittelwert sowohl mildere Bewertung als auch zufällig bessere Projektzuweisung bedeuten. Zwischen den beiden Runden lag ein Unterschied von 0,6 Punkten (Runde 2 höher).

Einschätzung: Für die hier durchgeführte Vergabe von Bonuspunkten (semesterbegleitende Studienleistung) halten wir diese Varianz für vertretbar. Für eine bestehensrelevante Prüfungsleistung erscheinen hingegen Maßnahmen wie Doppelbewertung oder andere Techniken zur Kalibrierung erforderlich.

Beobachtungen

Selbstselektion: 30% der zu Klausur Angemeldeten nahmen an der Messe teil. Im Vorjahr (damals noch ohne systematisches Bewertungsschema) bestanden Messe-Teilnehmende die Klausur deutlich häufiger als Nicht-Teilnehmende. Ein Kausalzusammenhang ist jedoch nicht belegt – der Effekt könnte durch Vorwissen oder Motivation erklärt werden.

Atmosphäre: Der Rahmen war erkennbar entspannter als bei klassischen mündlichen Prüfungen. Der vorgelagerte Hackathon (Teilnahme von ca. 50% der Messe-Teilnehmenden) trug zum Community-Building bei.

Externe Gäste: Neben Fakultätsmitgliedern besuchten auch ehemalige Kursteilnehmer die Messe – ein gewünschter Effekt zur Erhöhung der Sichtbarkeit der Arbeit von Studierenden und zur Steigerung der Selbstwirksamkeit.

Limitationen

Aufwand: Der Vorbereitungsaufwand (Raumgestaltung, Technik, Bewertenden-Briefing, Kommunikation) ist erheblich. Die Durchführung erforderte 7–9 bewertende Personen über einen Zeitraum von 2,5 Stunden.

Skalierung: Mit aktuell 30 verfügbaren Stehtischen ist die Kapazität pro Runde begrenzt. Bei weiterem Wachstum wären längere Messen oder zusätzliche Runden nötig.

Reichweite: Das Format erreicht primär bereits motivierte Studierende. Ob es als verpflichtendes, notenrelevantes Format funktioniert, ist offen.

Bewertungskonsistenz: Ohne Doppelbewertungen können wir nicht prüfen, ob zwei Bewerter dasselbe Projekt gleich einschätzen würden.

Erkenntnisse für Baustein 06

Die Projektmesse adressiert das Ausgangsproblem: Sie prüft Verständnis statt Urheberschaft. KI-generierter Code ist kein Problem, solange Studierende ihn erklären können. Die mündliche Interaktion macht Kompetenz sichtbar, die in schriftlichen Abgaben verborgen bleibt.

Das Format eignet sich als Ergänzung zu klassischen Prüfungen, nicht als Ersatz. Die Kombination aus Bonuspunkten und freiwilliger Teilnahme senkt die Stakes und ermöglicht Erprobung ohne Risiko für Studierende.

Für eine Übertragung auf andere Lehrveranstaltungen sind folgende Faktoren relevant: ausreichend Bewertungspersonal, geeignete Räumlichkeiten, klare Bewertungskriterien mit konkreten Nachfragen, und – optional – ein vorgelagertes Event (wie der Hackathon), das die Hemmschwelle senkt.

Anschlussformat: WIAI25-Exponate

Ausgewählte Projekte aus der Messe erhalten die Möglichkeit, als eigenständige Lehrveranstaltung (6 ECTS, Kategorie “Projekt”) weitergeführt zu werden. Ziel ist ein Exponat für das WIAI25-Jubiläumsfest am 26. Juni 2026.

Das Format folgt derselben Logik wie die Projektmesse: Studierende werden bei der Umsetzung begleitet, KI-Werkzeuge sind erlaubt und erwünscht, wenn das Projekt dadurch für das Zielpublikum attraktiver wird. Der Bewertungsfokus liegt auf der Live-Präsentation am Jubiläumsfest und der beobachtbaren Entwicklung der Studierenden über das Semester.

Das Bewertungsschema ist noch in Entwicklung. Mögliche Dimensionen:

- Qualität der Präsentation am Jubiläumsfest

- Fortschritt gegenüber dem Messe-Stand

- Umgang mit Feedback und Iteration

- Selbstständigkeit vs. benötigter Support

Dieses Anschlussformat erlaubt es, das Prinzip “Live-Performance statt Artefakt-Bewertung” auf einen längeren Zeitraum und höhere ECTS-Zahl zu skalieren.

Weiterführend

Weitere Eindrücke und Reflexionen sind im uni-mal-anders Blog erschienen.

Details zu Projektanforderungen, Ablauf und Anmeldung: inf.zone/projektmesse